概要:

人間はコミュニケーションを行う時、メッセージ全体の印象を100%とした場合に言語内容の占める割合は7%、音声と音質の占める割合は38%、表情としぐさの占める割合は55%という法則をアルバート・メラビアンは導き出しました。本プロジェクトはこの法則を基にWeb会議で会話のみだけだはなく非言語コミュニケーションを視覚化し、円滑な会議を目標としました。

背景:

人間はコミュニケーションを行う時、言葉よりも顔の表情・視線・身振りなどのほうが、より重要な役割を荷っていることがある。アルバート・メラビアン(1968) は、メッセージ全体の印象を100%とした場合に言語内容の占める割合は7%、音声と音質の占める割合は38%、表情としぐさの占める割合は55%という法則を導き出した。これにより言語コミュニケーションよりも非言語コミュニケーションの方が重要性が高いことが考えられる。

目的:

本プロジェクトでは音声と視線・表情・ジェスチャーを読み取り、非言語コミュニケーション能力向上を目的とする。

目標:

VR会議での使用を想定し、非言語コミュニケーションの伝達方法を追加することで内容理解力を深め会議の円滑な進行を目標とする。

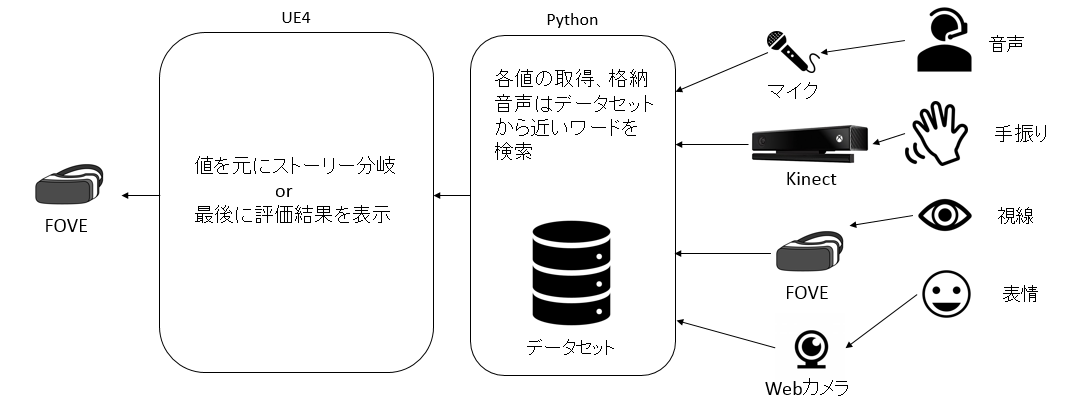

システム構成図:

完成予想図:

開発環境:

ハードウェア

- FOVE

- Kinect v1

- Web Camera

- Microphone

ソフトウェア

- Unreal Engine 4

- Blender

開発言語

- BluePrint

- C++

- Python

メンバー:

- 別府瞭 プロジェクトマネージャ、メインプログラマ

- 鈴木結貴 プログラマ

- 齊藤真生 プログラマ

- 竹田悠介 プログラマ

- 福井佑希 プログラマ

- コルドバユキコ メインデザイナ、モデラ